Comment Docker, image et Registry permettent une livraison plus rapide et plus sûre d'images multi-architecture

Comment Docker, image et Registry permettent une livraison plus rapide et plus sûre d'images multi-architecture

Partagez toute l'actualité

- 12 JUIN 2023

Les architectures utilisant des processeurs ARM sont de plus en plus populaires dans les environnements locaux, car elles offrent de meilleures performances à des coûts réduits. Cependant, la création d’une pipeline de livraison et de numérisation d’image pour ces architectures peut être un défi.

C’est là que le projet Docker, image et Registry entre en jeu.

Le projet vise à créer une pipeline de livraison et de scan d’image multi-architecture, en utilisant les processeurs ARM pour offrir de meilleures performances à des coûts réduits. (Vous le savez sûrement que les processeurs ARM consomment moins d’énergie pour la même efficacité qu’une puce Intel ou AMD).

Dans cet article, nous allons explorer en détail chaque étape de ce projet et comment il peut aider les développeurs à créer des images Docker pour les architectures multi-cœur et les publier sur une registry en toute sécurité. Nous allons également discuter des avantages de l’utilisation de Docker pour ce type de projet et des bonnes pratiques à suivre pour optimiser l’utilisation de Docker.

Qu'est-ce que c'est que Docker ?

Docker est une plateforme open-source qui révolutionne le déploiement et l’exécution des applications grâce à la conteneurisation. En utilisant Docker, les applications sont encapsulées dans des conteneurs légers et portables, qui offrent une isolation complète du système d’exploitation hôte. Cette isolation garantit que chaque application peut fonctionner de manière indépendante, sans interférer avec d’autres applications ou ressources.

De plus, Docker permet de créer des images de conteneurs qui contiennent tous les éléments nécessaires pour exécuter une application, assurant ainsi une répétabilité et une cohérence lors du déploiement.

Grâce à ces fonctionnalités, Docker simplifie grandement le déploiement et la gestion des applications, favorisant ainsi la portabilité, l’efficacité et la stabilité des environnements de développement et de production.

Les 5 étapes du projet :

1. Analyse de solutions disponibles :

La première étape consiste à analyser les différentes solutions disponibles pour répondre aux besoins du projet. Pour le projet Docker, image et Registry, l’analyse a comparé trois solutions : Docker Hub, Amazon ACR et GitHub Conteneur Registry. Après l’analyse, Docker Hub a été choisi pour répondre aux besoins du projet. Pour garantir une analyse approfondie, il est recommandé de prendre en compte les fonctionnalités, les coûts, la facilité d’utilisation et la compatibilité avec les besoins du projet.

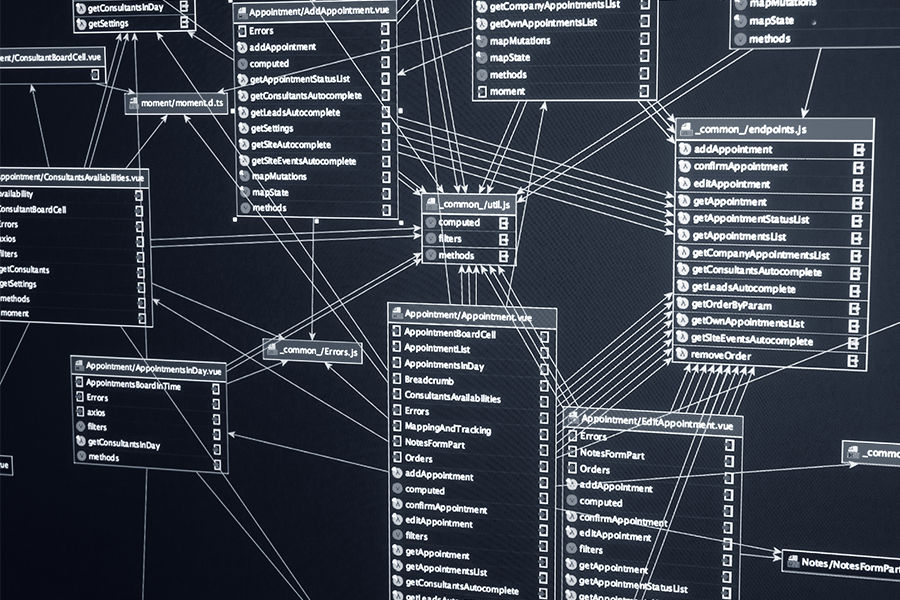

2. Création d’une image Toolbox pour ARM et x86

La deuxième étape consiste à créer une image SCAFE Toolbox pour les processeurs ARM et x86. Cette étape implique l’optimisation du Dockerfile et la numérisation avec Trivy. L’objectif est de créer une image mono-architecture en utilisant les outils présents dans le Dockerfile, ainsi que la partie multi-architecture.

Il est important d’optimiser les layers et d’analyser le Dockerfile pour maximiser le code. Il est également recommandé de respecter les bonnes pratiques de Docker et d’utiliser des outils de sécurité pour garantir la qualité de l’image.

3. Optimisation du Dockerfile

La troisième étape consiste à optimiser le Dockerfile. L’objectif est de limiter le code pour le rendre plus simple et compréhensible pour les utilisateurs. Il est recommandé de séparer les instructions RUN autant que possible, d’utiliser des versions spécifiques des packages et des images de base pour éviter les conflits, et de supprimer tous les fichiers inutiles et temporaires.

4. Scan de sécurité avec Trivy

La quatrième étape consiste à effectuer un scan de sécurité avec Trivy. Cette étape est importante pour garantir la sécurité de l’image. Trivy est un outil open-source qui permet de détecter les vulnérabilités et les erreurs de configuration dans les images Docker. Il est recommandé d’utiliser cet outil pour garantir que l’image ne présente aucun risque de sécurité avant de la mettre en production et le plus souvent que possible (intégrer à une pipeline de préférence).

5. Création d’un pipeline pour faciliter le versioning

La cinquième et dernière étape consiste à créer un pipeline de versioning. Cette étape est importante pour faciliter la gestion des différentes versions du code et pour avoir une documentation claire. Il est recommandé d’utiliser des outils tels que Gitlab pour la gestion de code source, Confluence pour la documentation et Jenkins pour l’automatisation de la livraison continue.

Voici nos quelques conseils pour utiliser efficacement Docker, image et registry :

1. Utilisez les tags d’image de manière judicieuse : Les tags sont utilisés pour identifier une image dans la registry. Il est important de choisir un tag significatif pour chaque image. Par exemple, utilisez des numéros de version pour les images qui doivent être mises à jour régulièrement, ou utilisez des tags de date pour identifier les images générées à une certaine date.

2. Evitez les images volumineuses : Il est important de garder les images aussi légères que possible. Plus une image est volumineuse, plus elle est lente à télécharger, à déployer et à exécuter. Évitez d’ajouter des fichiers inutiles à l’image et supprimez tout ce qui n’est pas nécessaire.

3. Utilisez une registry privé : Il est fortement recommandé d’utiliser une registry privé pour stocker les images de votre entreprise. Cela vous permettra de garder le contrôle sur vos images et de garantir leur sécurité. Une registry privé peut également vous offrir des fonctionnalités supplémentaires, telles que la gestion des droits d’accès, la création de flux de travail personnalisés ou des scan de sécurité avancée.

4. Utilisez les outils pour automatiser les tâches : Les tâches de gestion des images Docker peuvent être fastidieuses. Utilisez des outils tels que Ansible, Chef, ou Puppet pour automatiser les tâches courantes, telles que la création, la suppression et la mise à jour des images.

5. Faites des tests de sécurité : Avant de publier une image dans le registry, il est important de s’assurer qu’elle est sûre. Utilisez des outils de test de sécurité tels que Quay Clair ou Anchore pour analyser les images et trouver des vulnérabilités.

6. Utilisez un système de contrôle de version : Il est important de garder une trace de toutes les modifications apportées aux images. Utilisez un système de contrôle de version tel que Git pour stocker les fichiers de configuration Dockerfile et garder une trace de toutes les modifications.

7. Utilisez une méthode de déploiement cohérente : Il est important d’utiliser une méthode cohérente pour déployer les images sur les différents environnements. Utilisez des outils tels que Kubernetes, Swarm, ECS, Redhat OpenShift ou Docker Compose pour déployer les images de manière cohérente et fiable.

8. Évitez les dépendances externes : Évitez d’avoir des dépendances externes dans vos images Docker. Cela peut causer des problèmes de compatibilité et rendre vos images plus difficiles à gérer. Si vous devez avoir des dépendances externes, utilisez un système de gestion de dépendances tel que pip ou npm pour les gérer.

9. Faites attention à la taille de l’historique des images : L’historique des images contient toutes les couches de l’image et peut être volumineux. Évitez d’inclure des informations sensibles dans l’historique de l’image et assurez-vous de supprimer toutes les couches inutiles pour réduire la taille de l’historique.

10. Effectuez des mises à jour régulières : Il est important de garder les images à jour pour garantir la sécurité et la stabilité de votre environnement.

En conclusion :

En conclusion, le projet décrit est un excellent moyen de créer une pipeline de livraison et de scan d’image pour une architecture multi-cœur utilisant des processeurs ARM, tout en offrant de meilleures performances à des coûts réduits.

Contactez les équipes de SCAFE pour en savoir plus !

Rencontrons-nous !

La collecte des informations demandées est nécessaire au traitement de votre demande par SCAFE, responsable de traitement. Elle vous permettra d’être contacté(e) dans le cadre de votre requête. Ces informations collectées pourront être utilisées à des fins de prospection. Vous disposez d’un droit d’accès, de rectification, d’opposition et de suppression des données qui vous concernent. Pour les exercer, merci de consulter notre page Gestion de mes données personnelles. Nous vous invitons à prendre connaissance de notre Politique de protection des données.

À la une

- 5 AOÛT 2023

Helm, un outil indispensable

Helm fait partie de l’écosystème Kubernetes et permet de gérer les applications Kubernetes en les packagant, les créant et les déployant…

- 26 JUILLET 2023

GitLab Terraform

Terraform est un outil open source d’infrastructure en tant que code (IaC) créé par HashiCorp. C’est outil de codage déclaratif, Terraform permet aux développeurs d’utiliser un langage de configuration de haut niveau appelé HCL…

- 3 JUIN 2023

Cybersécurité & Cloud

Dans le monde numérique actuel, les entreprises et les organisations dépendent de plus en plus du Cloud pour stocker et gérer leurs données, la cybersécurité est devenue un enjeu majeur…